这些顶尖数学家正在对人工智能进行测试

大型语言模型在应对研究级别的数学难题时,显得有些力不从心。而要准确评估它们表现得究竟有多差,终究还是得靠人类。

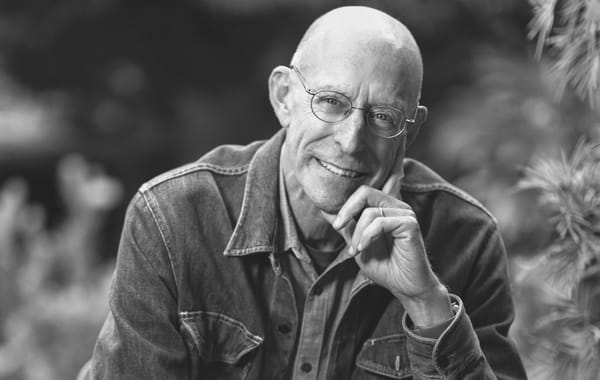

就在几周前,一位高中生给马丁·海雷尔发去了一封邮件。海雷尔以其惊人的创造力在数学界闻名遐迩,而这位少年则是一位对数学充满憧憬的后起之秀。然而,随着人工智能的崛起,少年陷入了迷茫。他在信中写道:“我很难看清现在的局势。感觉这些模型每天都在进化,恐怕要不了多久,我们这些人就会变得毫无用处。”

他提出了一个灵魂拷问:“如果我们拥有了一台解题能力远超人类的机器,数学是否也会随之失去它的一部分魔力?”

海雷尔博士曾于2014年摘得数学界的最高荣誉——菲尔兹奖,并于2021年获得了奖金丰厚的“突破奖”。目前,他在瑞士洛桑联邦理工学院和伦敦帝国理工学院两地任教。在给这位学生的复信中,他观察到,许多行业目前都在为“AI导致职业过时”的前景而感到焦虑。

“但我认为,数学其实是相当‘安全’的,”海雷尔博士宽慰道。他指出,作为聊天机器人核心技术的大型语言模型(LLM),虽然现在非常擅长解决那些人为编造的题目,但是,“我至今还没见过哪个LLM能提出真正具有原创性的想法或概念。”

海雷尔博士在讨论一篇名为《初次发酵》(First Proof)的新论文时,提到了这段往事。这篇论文是由他与几位数学家共同完成的,合作者包括斯坦福大学的穆罕默德·阿布扎伊德、哈佛大学的劳伦·威廉姆斯,以及在旧金山湾区经营MathSci.ai咨询公司的塔玛拉·科尔达。

注:英语 Proof 既有发酵的意思,也有证据/证明的意思。First Proof 在这里显然是一个双关表达。

这篇论文记录了一项近期启动的实验。研究人员从作者们尚未发表的科研成果中,提取出真实的测试题目进行汇总,试图以此为基准,对人工智能的数学能力给出一个真正有分量的评估。

作者们希望,这项研究能为那些宣称数学已被AI“攻克”的夸张言论降降温,增加一些理性的思考。他们也想借此消除过度炒作带来的负面影响——比如吓跑未来的数学苗子,或是让科研资助者望而却步。

“虽然商业化的AI系统确实已经进化到了可以作为数学家辅助工具的水平,”作者们在文中写道,“但在没有专家实时引导的情况下,AI系统独立解决研究级数学问题的真实水平究竟如何,目前还是个未知数。”

一些人工智能公司在评估LLM的脱机表现时,往往会使用一些被数学家称为“刻意设计”或“局限性强”的题目。有时,这些公司也会邀请数学家出题,并支付每题约5000美元的报酬。(值得注意的是,《初次发酵》项目的所有作者均与AI公司没有任何利益往来。)

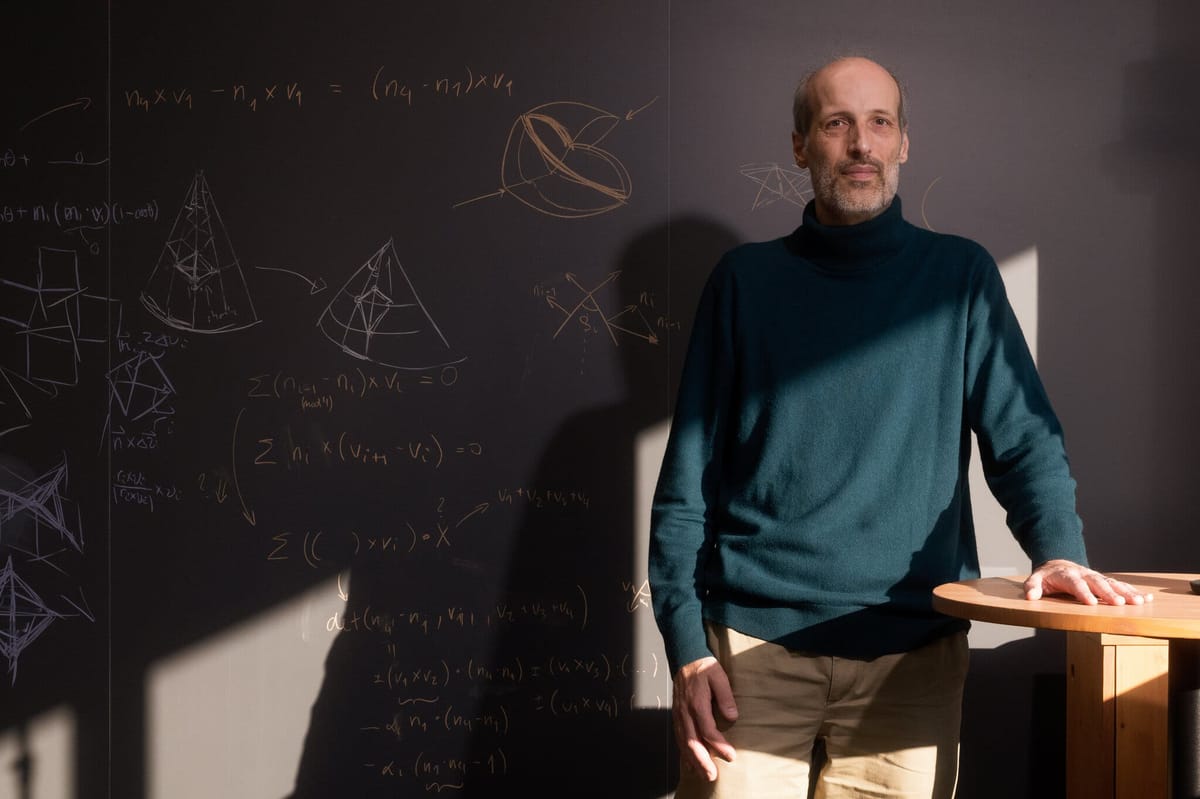

去年4月,曾在2017年获得“数学新视野奖”的阿布扎伊德博士就拒绝了这样一份邀请。他说:“我觉得,我们需要的是一项更广泛、更独立且更公开的努力。”他补充道,《初次发酵》正是这方面的初步尝试。

“我们的目标,是对人工智能的科研能力进行一次客观的体检,”最近刚获得古根海姆奖学金和麦克阿瑟奖学金的威廉姆斯博士如是说。